Quantum Software量子ソフトウェア

量子コンピューティングが

導く未来の素粒子物理学

概要

量子コンピュータには、古典コンピュータよりもはるかに高速に解ける問題があることが知られています。古典コンピュータが情報 を0か1の「ビット」で処理するのに対し、量子コンピュータでは0と1だけでなく、0でも1でもない状態を「量子ビット」を使って計算します。量子ビットが50個あれば、原理的には1,000兆通りもの状態を同時に表現することが可能です。この表現能力の高さはミクロな実体としての量子の波動性を利用したものです。本センターが取り組む素粒子実験はまさにミクロな粒子としての素粒子を扱っており、その素粒子の複雑な振る舞いを量子コンピュータを使うことで上手く計算できるようになるのではないかと考えています。現在の量子コンピュータは実用的な問題を解くには課題も多いですが、400個を超える量子ビットを備えた量子コンピュータも実現されており、将来に備えた準備が急務です。

量子ソフトウェアグループでは、主に3つのテーマで研究を進めています。1つ目は「量子AI(人工知能)の研究」 です。AIという言葉は多義に使われますが、素粒子実験では特に機械学習を指します。加速器が作る大量のデータから、シグナル(未知の粒子を含む現象)とバックグラウンド(すでに存在が分かっている現象)を高い精度で効率よく区別する必要があり、そうした解析には機械学習技術が必須です。2029年開始予定の高輝度LHC実験ではデータ量がさらに一桁以上増えるため、量子コンピュータを活用した量子機械学習が期待されています。

2つ目は「素粒子反応の量子シミュレーション研究」です。加速器の中ではさまざまな素粒子が生成され、それらが別の素粒子へと変換・崩壊する過程を起こします。こうした反応過程には、量子コンピュータによって古典計算よりも非常に効率的にシミュレートできる部分が含まれています。現在の量子コンピュータを使ってその基礎反応を計算する手法を研究し、より複雑な多次元反応へと拡張する取り組みを進めています。

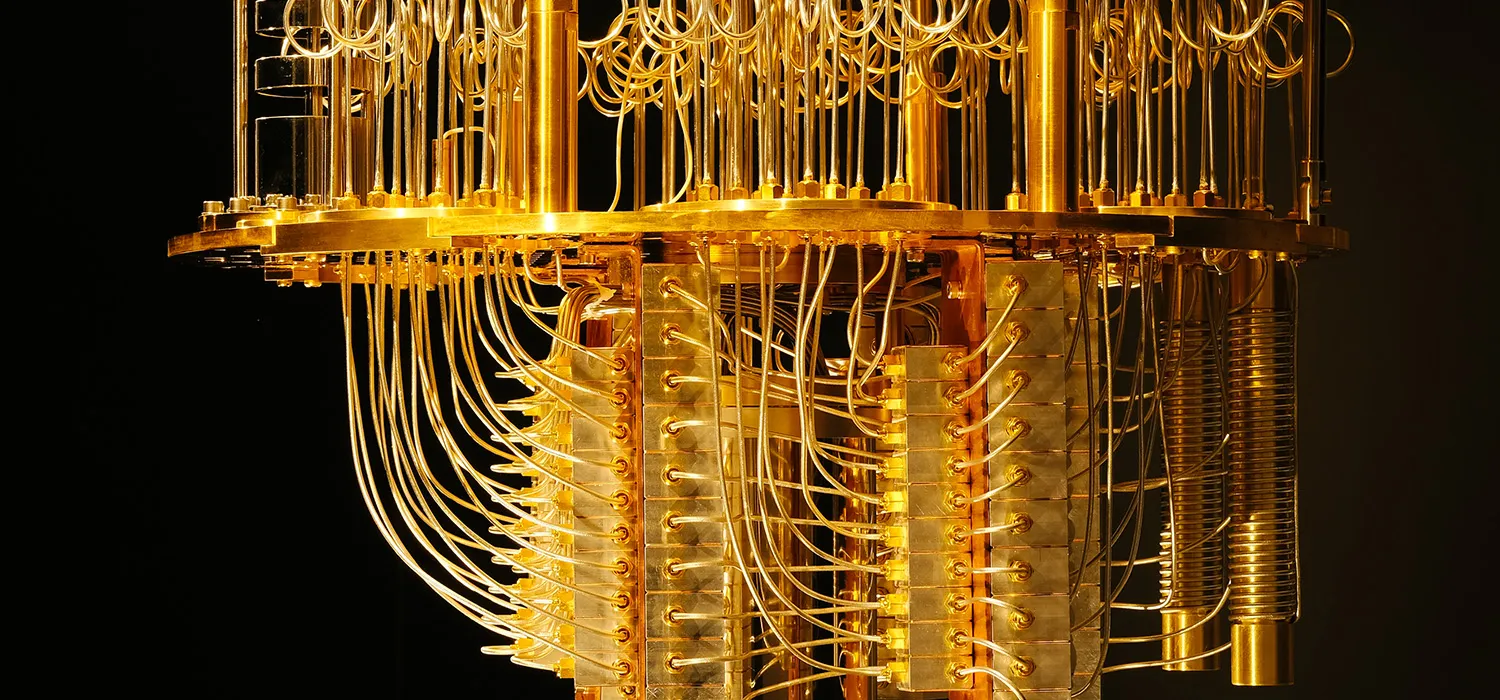

3つ目は「量子コンピュータのハードウェア研究」です。開発した量子AIアルゴリズムや量子シミュレーション を量子コンピュータで動かすには、ハードウェアへの効率の良い実装と制御が欠かせません。専用超伝導量子ビットの開発やその物理実験への応用、最低3準位を利用した量子トリット制御の実装など、量子ハードウェアグループとの連携を活かした研究開発も進めています。

一連の研究は、LHC-ATLAS実験を基点に国際共同研究で進めています。米国・LBNLとFermi lab、シカゴ大学、スイスのCERNの4つが大きな軸となっています。また、本学が2019年に締結したIBMとのパートナーシップに基づき、知識集約型社会へのパラダイムシフトを目指す「東京大学量子イニシアティブ構想」にも関わっています。基礎研究から技術実証、オープンイノベーシ ョン、人材育成に至るまで産学官で取り組み、国際的な連携と新たな戦略で未来に繋げる時代に突入しています。